AI

Einleitung

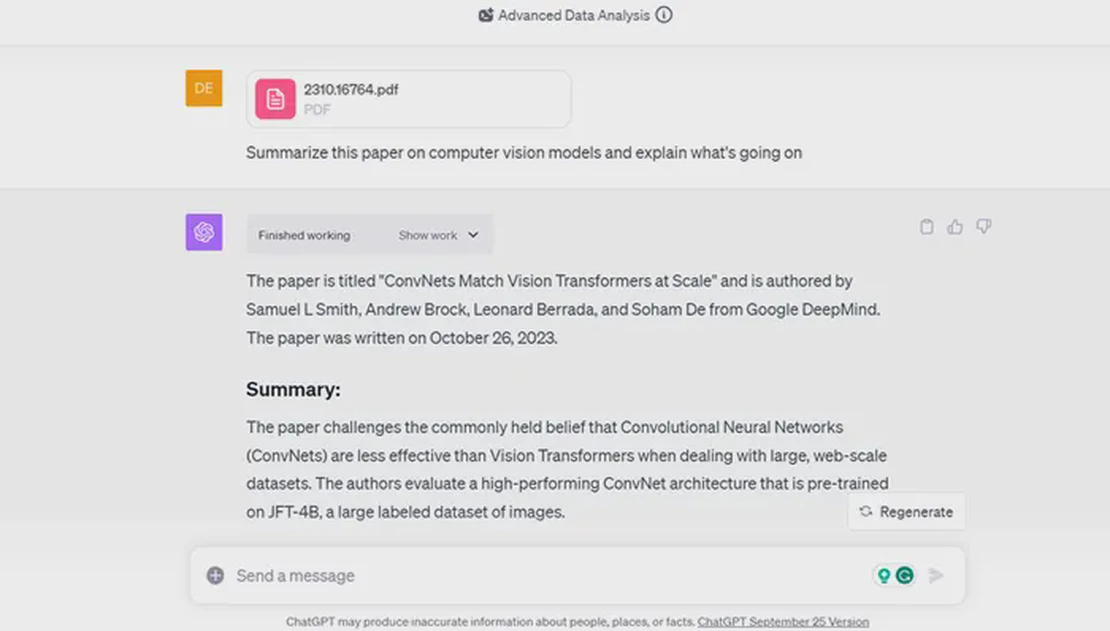

Die fortschrittlichen Sprachmodelle wie ChatGPT haben zweifellos beeindruckende Fähigkeiten, wenn es darum geht, menschenähnlichen Text zu generieren und auf Fragen zu antworten. Allerdings ist es wichtig zu verstehen, dass diese Modelle nur über Allgemeinwissen verfügen und keinen Zugang zu kontextspezifischen Informationen haben. Zudem sind sie oft auf einem älteren Wissensstand, was bedeutet, dass sie möglicherweise nicht über die aktuellsten Informationen verfügen.

Einleitung

In der Welt der künstlichen Intelligenz (KI) haben sich große Sprachmodelle wie GPT (Generative Pre-trained Transformer) als leistungsstarke Werkzeuge für eine Vielzahl von Anwendungen etabliert. Unternehmen sollten jedoch vorsichtig sein, sich zu stark auf diese Modelle zu verlassen. Während sie Genauigkeit und Skalierbarkeit bieten, haben sie auch ihre Grenzen. Sie können aufgrund von Einschränkungen bei den Trainingsdaten voreingenommene oder falsche Antworten liefern und sind nicht in der Lage, den menschlichen Kontext und Feinheiten vollständig zu verstehen.

Das Problem: 75% der Firmen verbieten die Nutzung von ChatGPT

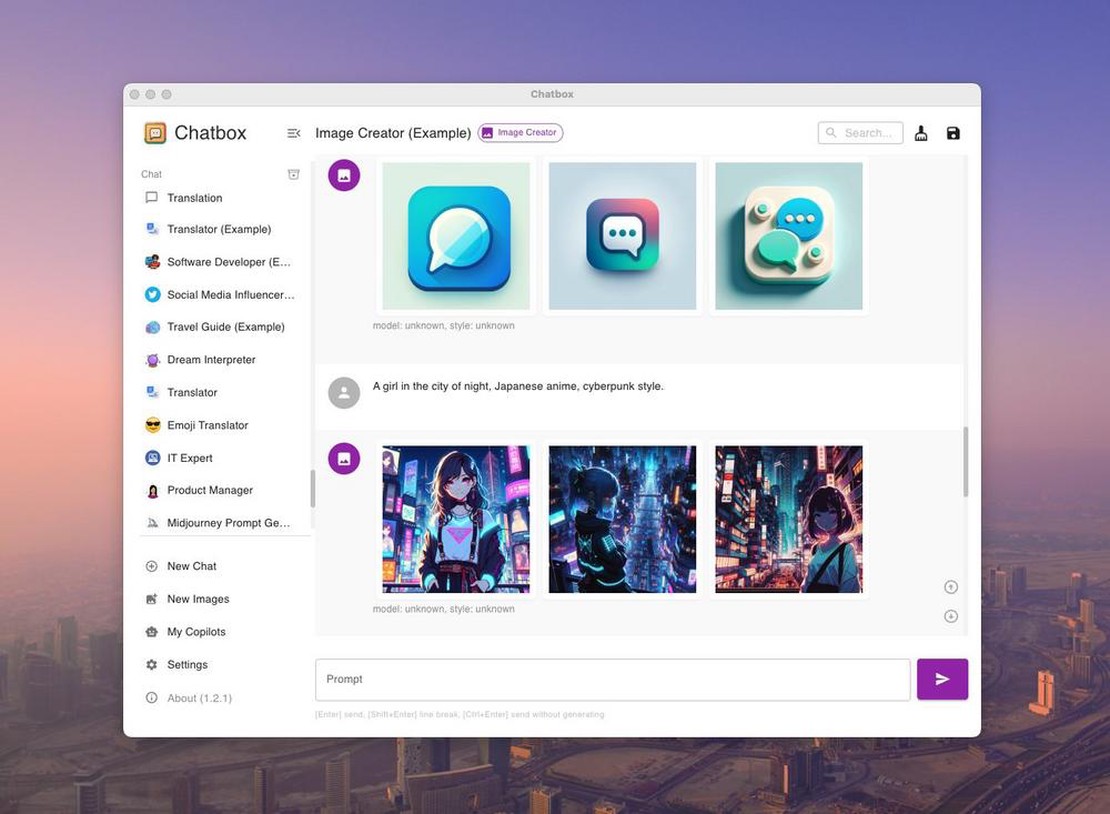

Trotz der anfänglichen Begeisterung für Generative KI-Tools wie ChatGPT, ziehen Unternehmen aufgrund wachsender Datenschutz- und Cybersicherheitsbedenken in Erwägung, deren Verwendung zu beschränken. Die Sorge besteht vor allem darin, dass diese KI-Tools Nutzerdaten speichern und aus ihnen lernen, was potenziell zu unbeabsichtigten Datenlecks führen könnte. Obwohl OpenAI, der Entwickler von ChatGPT, eine Opt-out-Option für das Training mit Nutzerdaten bietet, bleibt die Frage, wie die Daten innerhalb des Systems gehandhabt werden, unklar. Zudem fehlen klare gesetzliche Regelungen zur Verantwortung bei durch KI verursachten Datenverletzungen. Unternehmen sind daher zunehmend vorsichtig und warten ab, wie sich die Technologie und ihre Regulierung weiterentwickeln.